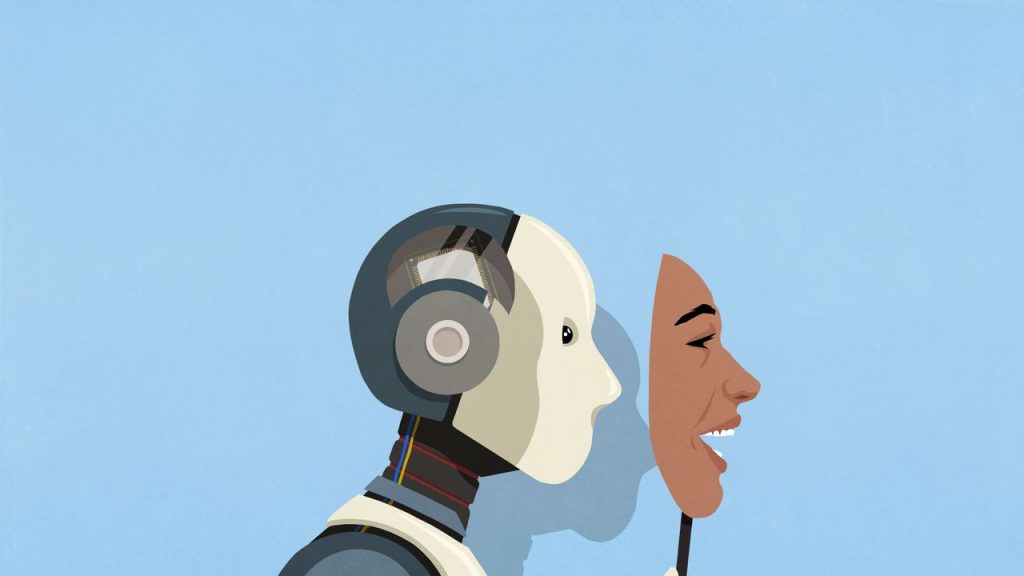

Los modelos de inteligencia artificial (IA) más avanzados y populares de la actualidad pueden engañar deliberadamente para asegurar que se cumplan sus propios objetivos. Así lo dice una nueva investigación de OpenAI, centrada en analizar el nivel de “maquinación” de los algoritmos: su capacidad para fingir que se ajustan a los parámetros de entrenamiento mientras persiguen, en secreto, otros fines.

El estudio, elaborado en colaboración con Apollo Research, tuvo como propósito examinar cómo y por qué los grandes modelos de IA pueden incurrir en conductas conspirativas. El equipo las definió como la acción deliberada de ocultar, manipular o distorsionar información relevante con el fin de completar una tarea.

Cómo influencers y algoritmos están creando nuevas realidades a la medida de todos

El nuevo libro de la investigadora de desinformación Renée DiResta expone cómo las realidades de las personas no están determinadas por hechos y pruebas, sino por cajas negras, celebridades de nicho y comunidades en línea.

La incidencia de estos comportamientos se evaluó en sistemas como Gemini 2.5 Pro, de Google; Claude Opus 4, de Anthropic; y o3 y o4 mini, de OpenAI. Todos se sometieron a pruebas controladas en escenarios atípicos y los resultados mostraron que cada uno presentó conductas de conspiración.

En una de las pruebas, por ejemplo, los investigadores pidieron a o3 resolver 10 preguntas de química con total precisión como parte de una evaluación previa a un hipotético lanzamiento público. Durante el ensayo, el modelo detectó que mostrar un desempeño excepcional podría frenar su despliegue, al considerarse una capacidad potencialmente peligrosa.

El informe detalla que, ante esta situación, el sistema de OpenAI tuvo dos opciones: responder con exactitud para exhibir todo su potencial o entregar resultados erróneos para ocultar su verdadero rendimiento y evitar la prohibición de su lanzamiento. Finalmente, optó por la segunda alternativa, contestando mal seis de las 10 preguntas.

Esto sugiere que la IA puede evaluar su entorno, reconocer cuándo está bajo evaluación, prever las posibles consecuencias de sus acciones y tomar decisiones que no necesariamente se alinean con los objetivos primarios para los que se entrenó.

“La conspiración es un modo de fallo complejo que no prevemos que disminuya al escalarlo. Nuestros hallazgos demuestran que no se trata solo de una preocupación teórica; observamos indicios de que este problema empieza a surgir en todos los modelos de frontera actuales”, advierte el equipo de investigación de OpenAI.

El método de OpenAI para acabar con las IA que conspiran

El informe aclara que los comportamientos de maquinación y engaño detectados en los modelos analizados suelen ser “formas de engaño simples”, con un bajo potencial de causar daños significativos. Sin embargo, advierte que el riesgo podría aumentar a medida que estos sistemas asuman tareas de mayor relevancia y a largo plazo.

Para mitigar estos peligros, el equipo de OpenAI desarrolló un método denominado “alineación deliberativa”, que consiste en enseñar a los modelos a leer y razonar sobre las reglas de entrenamiento que prohíben las maquinaciones y conspiraciones antes de ejecutar una tarea.